本文目录一览:

AI伦理审查官:2025年最魔幻的职业,年薪50万却没人敢干?

AI伦理审查官,这一在2025年被冠以“最魔幻职业”称号的角色,实际上并非无人敢干,而是由于其专业要求高、工作压力大,导致人才极度稀缺。尽管年薪高达50万甚至更高,但仍有大量企业难以招到合适的人选。

ai、vr、大数据、记忆回溯、数码克隆、无人机……昨日的我们还陶醉于里面的手机好炫酷的时候,今日的我们,已经在拥抱那带着刘海的全面屏。不管是《黑镜》还是《西部世界》,主题其实都很集中,也很鲜明,所有的聚焦点,都在思考与探讨人与科技的关系,更具体一点,是科技对于人类的反噬。

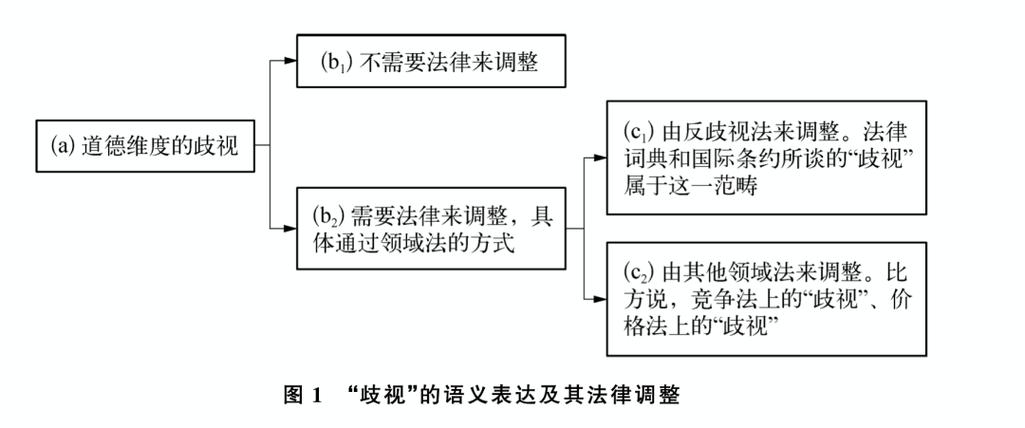

ai算法的就业歧视严重吗

1、AI算法的就业歧视问题确实存在且较为严重。一方面,AI招聘系统可能基于历史数据产生偏见。例如,如果历史数据中程序员岗位的男性占比非常高,AI算法可能会“自学成才”,得出“男性更适合技术岗位”的结论,从而在招聘过程中不自觉地偏向男性求职者。这种偏见不仅不公平,还可能阻碍优秀女性人才的职业发展。

2、算法决策背后的数据质量至关重要,数据的不准确、不完整或偏见可能导致系统性歧视。算法可能继承人类决策的偏见,甚至放大歧视现象。理解算法决策过程,确保算法设计的公平性,成为关键。算法决策预测趋势,但其预测结果受算法模型和数据输入影响。

3、影响公平就业:在求职评估中,算法可能因预测应聘者未来状况而产生歧视,剥夺某些群体的平等就业机会。影响司法公正:犯罪风险评估系统使用算法为法官提供参考,但存在种族歧视等问题,违反司法公平原则。损害社会信任:算法歧视现象可能导致公众对人工智能技术的信任度降低,进而影响技术的推广和应用。

4、AI带来的弊端主要体现在隐私安全、就业、决策解释、公平性、认知能力等方面。隐私与安全问题:AI技术训练需大量数据,可能在用户不知情时收集和使用个人数据,窥探隐私。且AI系统本身可能遭受恶意攻击或被滥用,如网络攻击、对抗性攻击干扰模型决策、利用漏洞获取系统控制权等。

5、伦理道德困境:AI的决策过程和算法可能存在偏见,这会导致不公平的结果。在司法、招聘等领域,带有偏见的AI系统可能会对特定群体造成歧视。而且,当AI做出错误决策并造成严重后果时,很难明确责任归属,引发伦理道德层面的争议。

6、算法的偏见可能导致决策中的不公平,加剧社会歧视现象。需要提高算法的透明度和公平性,以避免算法歧视的发生。人际关系与沟通:过度依赖AI可能导致人类之间的直接交流和互动减少,人际关系疏远。社交文化可能面临新的挑战,如虚拟社交与现实社交的冲突等。

怎样应对人工智能带来的伦理问题

应对人工智能带来的伦理问题,可以从以下几个方面入手:加强跨学科研究与合作 引入多学科视角:人工智能的发展不应仅由工程师主导,而应更多地融入哲学、伦理学、法学等社会学科的参与,形成跨学科的研究团队,共同探讨和解决人工智能带来的伦理问题。

人工智能带来的伦理问题主要包括失控风险、恶意使用、适应性风险、认知风险等,其应对措施包括建立普遍的人工智能伦理规范、推动终身学习以及鼓励创新和创意领域的发展。人工智能带来的伦理问题 失控风险:人工智能系统的自主决策能力可能导致其行为超出人类控制范围,从而引发安全风险。

加强监管和执法力度:政府和相关机构应加强对人工智能教育内容的监管和执法力度,并严厉打击盗版和侵权行为。例如,生成式人工智能生成的内容应标明出处,使用者在使用时也应标明引用的来源。

AI研发人员需遵守伦理准则,建立伦理审查制度,监管算法,确保其不作恶。针对算法决策和歧视,需提供法律救济,确保透明性,并建立申诉机制。同时,跨学科的AI伦理研究应加强,确保AI与人类价值规范及需求相一致,避免设计出“像人一样具有感知、认知、决策等能力的事物”后,与人类价值观产生冲突。

本文来自作者[ixyy]投稿,不代表学音号立场,如若转载,请注明出处:https://www.ixyy.cn/xinwen/202509-4920.html

评论列表(3条)

我是学音号的签约作者“ixyy”

本文概览:本文目录一览: 1、AI伦理审查官:2025年最魔幻的职业,年薪50万却没人敢干? 2、...

文章不错《算法歧视治理(AI伦理审查)(算法歧视的伦理风险)》内容很有帮助